目錄

GPU 主機

LLM 模型本地部署的價值與挑戰

GPU 主機 – 隨著 ChatGPT、LLaMA、DeepSeek 等大型語言模型(LLM)廣泛應用,越來越多企業與開發者希望將 LLM 模型自建於本地或 GPU 實體主機上。這樣不僅能取得更高的資料控制權,避免私密資訊外洩,也能有效降低長期使用成本,並規避商業 API 在頻率、使用量、功能上的限制與資安疑慮。

然而,部署 LLM 模型的第一道門檻往往是環境建置。從 CUDA 驅動的版本對應、PyTorch 的安裝,到 HuggingFace 模型快取與推論引擎選型,都是需要考量的技術細節。如果沒有明確指引,往往容易在初期階段耗費大量時間摸索。

這篇文章將以平易近人的方式,帶你從挑選 GPU 主機開始,逐步說明環境建置、部署流程、模型上線、API 串接、容器化管理與後續運維建議,協助你成功將 LLM 模型部署到實體主機,快速打造自己的本地 AI 推論平台。

部署前準備與主機配置建議

在正式開始部署模型之前,先別急著安裝程式!我們需要先確認你的 GPU 主機硬體夠力、環境設定相容。這一節會用通俗的方式,帶你了解應該挑選哪一張顯卡(GPU)、要準備多少記憶體、該安裝哪些驅動與開發工具。只要照著這些建議來設定,就能大幅降低部署錯誤的風險,幫你更順利地讓 LLM 跑起來。

若你需要部署如 DeepSeek-V2 671B、GPT-4 級模型,請注意其對 GPU 記憶體、節點互聯頻寬與容器調度架構(如 Slurm、Ray、KubeRay)要求遠高於單卡部署,建議規劃多節點 H100 或 B100 集群,並提前測試資料同步與分片載入機制。

1️⃣ 選擇合適的 GPU 主機

以下為常見主流 LLM 模型規模對應的 GPU 配置建議,適用於 LLaMA、Vicuna、DeepSeek、Baichuan 等模型系列。此外,部分模型(如 DeepSeek-VL、Yi-34B、Mixtral)因支援多模態或分散式推論,對 GPU 記憶體、頻寬與儲存速度要求更高,建議提前確認官方需求。

以下配置為建議的最低硬體需求,適用於單卡部署條件下的基本穩定運行。若你希望獲得更高效能或支援多使用者併發,建議選擇更高階硬體。

依照你想部署的模型大小與使用情境,選擇 GPU 主機 配置:

模型規模 | 推薦 GPU | VRAM 建議 | 硬體建議 |

|---|---|---|---|

小型(7B) | RTX 3090 / A10 / L4 | 24GB 以上 | 8 核心 CPU / 64GB RAM / 1TB NVMe |

中型(13B~33B) | RTX 4090 / A100 | 40GB 以上 | 多核心 CPU / 128GB RAM |

大型(65B~70B) | A100×2 / H100×2 / 多卡 | 80GB×2 以上 | 高速儲存 / 多 GPU NVLink |

超大型(175B~671B) | H100×4~8 / B100×8 / 多節點集群 | 每節點 80GB×4 以上 | 高速網路互聯 / 多節點儲存 / Slurm 管理 |

2️⃣ 安裝基本環境(CUDA / 驅動 / PyTorch)

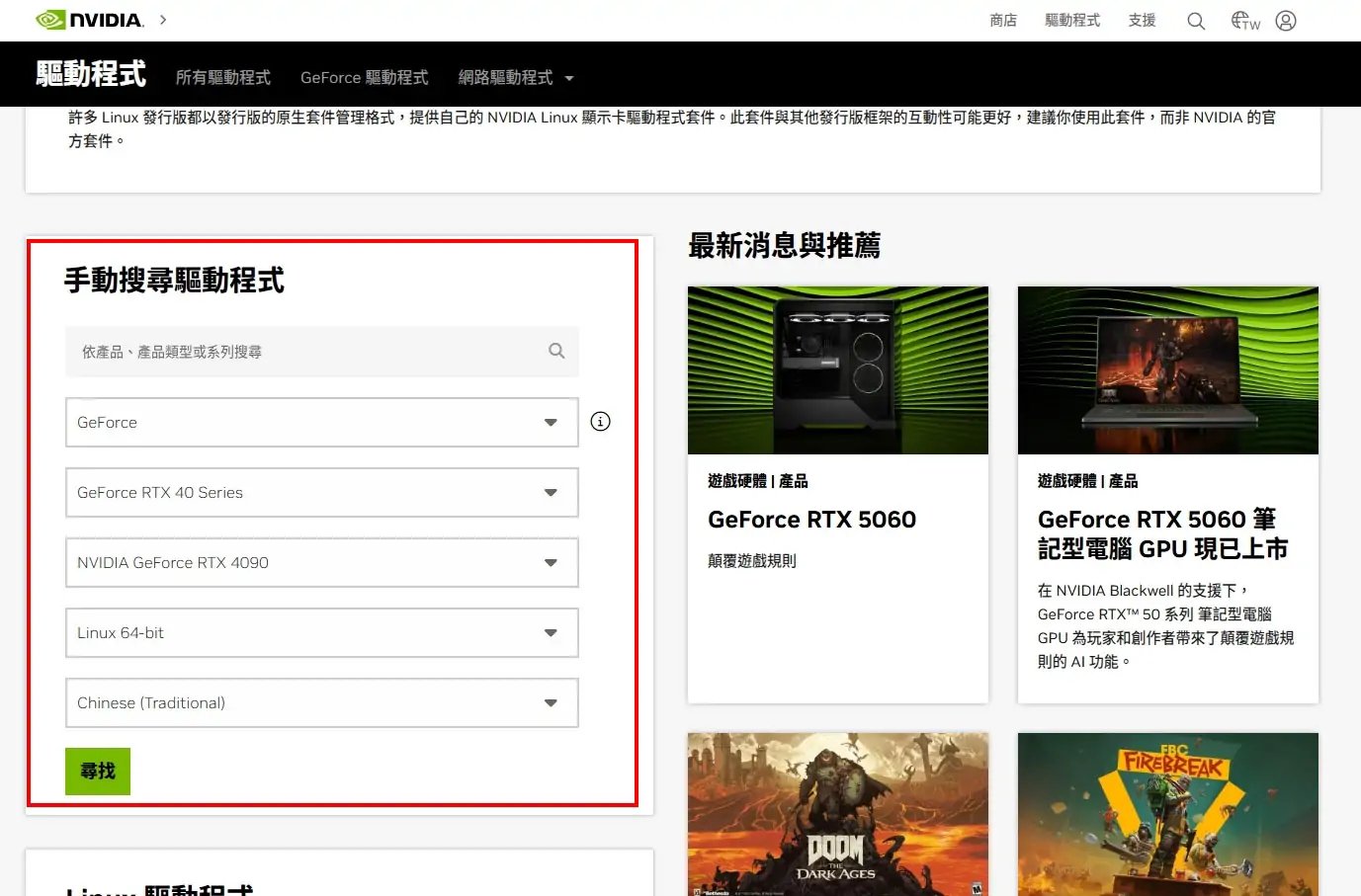

驅動安裝:建議使用官方網站下載最新版 NVIDIA Driver

CUDA 工具包:建議安裝與 PyTorch 相容的版本

安裝指令:

安裝 nvidia 顯示卡驅動

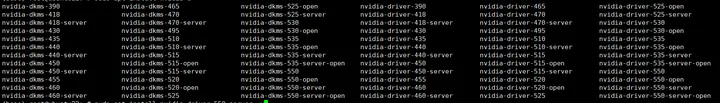

apt 安裝方式:安裝驅動之前可能要更新鏡像來源

sudo apt update -y

sudo apt install nvidia-driver-550-server -y

編譯安裝的方式,但不推薦現安裝驅動建議透過apt方式

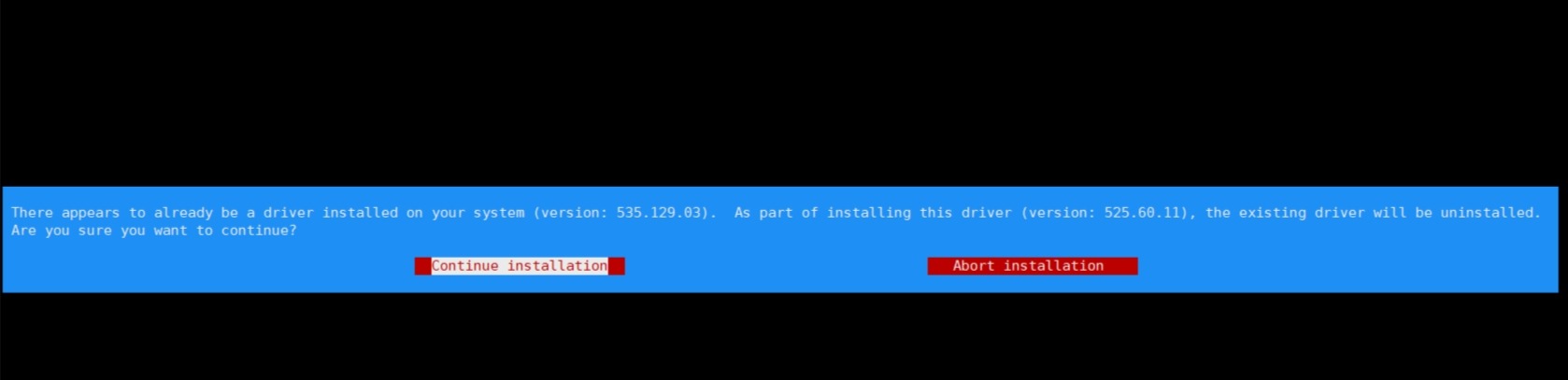

驅動可以從nvidia官網下載安裝最新的顯示卡驅動,cuda version表示支援的最高的cuda版本,相容於該版本以下的cuda。下載到伺服器上後執行

sh NVIDIA-Linux-x86_64-535.113.01.run -no-x-check -no-nouveau-check -no-opengl-files --no-cc-version-check --kernel-source-path="/usr/src/kernels/linux-headers-generic4"

注意:“/usr/src/kernels/linux-headers-generic4” 這個是系統的核心版本,根據自己的核心版本修改對應參數(例如:/usr/src/kernels/linux-headers-5.4.0-42-generic)。

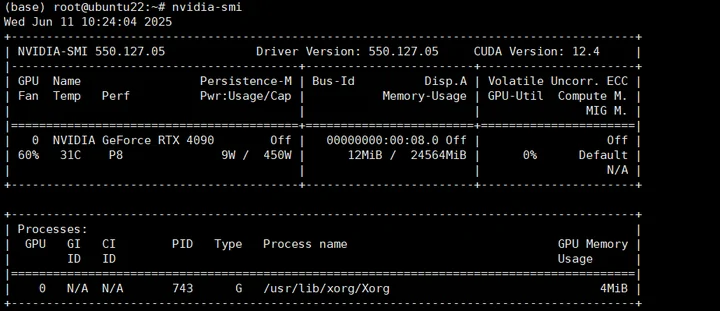

進入該介面後面都按預設不要做修改。安裝完成後執行 nvidia-smi 就能驗證驅動是否安裝完成了。

Nvidia官方各版本下載地址。

CUDA Toolkit Archive | NVIDIA Developer

以下提供 Linux 版本的下載位址與安裝方式

wget https://developer.download.nvidia.com/compute/cuda/12.9.1/local_installers/cuda_12.9.1_575.57.08_linux.run

sudo sh cuda_12.9.1_575.57.08_linux.run

wget https://developer.download.nvidia.com/compute/cuda/12.8.1/local_installers/cuda_12.8.1_570.124.06_linux.run

sudo sh cuda_12.8.1_570.124.06_linux.run

wget https://developer.download.nvidia.com/compute/cuda/12.6.3/local_installers/cuda_12.6.3_560.35.05_linux.run

sudo sh cuda_12.6.3_560.35.05_linux.run

wget https://developer.download.nvidia.com/compute/cuda/12.5.1/local_installers/cuda_12.5.1_555.42.06_linux.run

sudo sh cuda_12.5.1_555.42.06_linux.run

wget https://developer.download.nvidia.com/compute/cuda/12.4.1/local_installers/cuda_12.4.1_550.54.15_linux.run

sudo sh cuda_12.4.1_550.54.15_linux.run

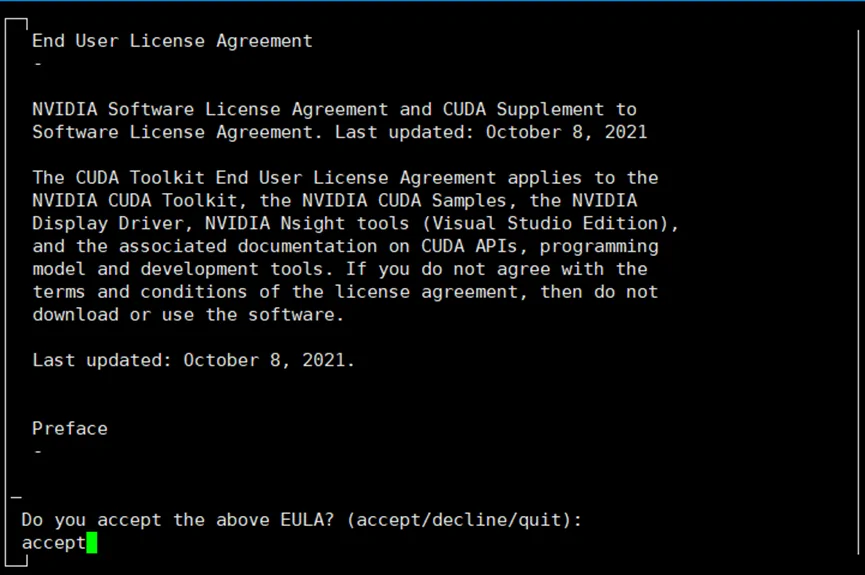

下載後軟體包後在軟體包執行 sh 命令

在這個介面輸入 accept 然後 enter

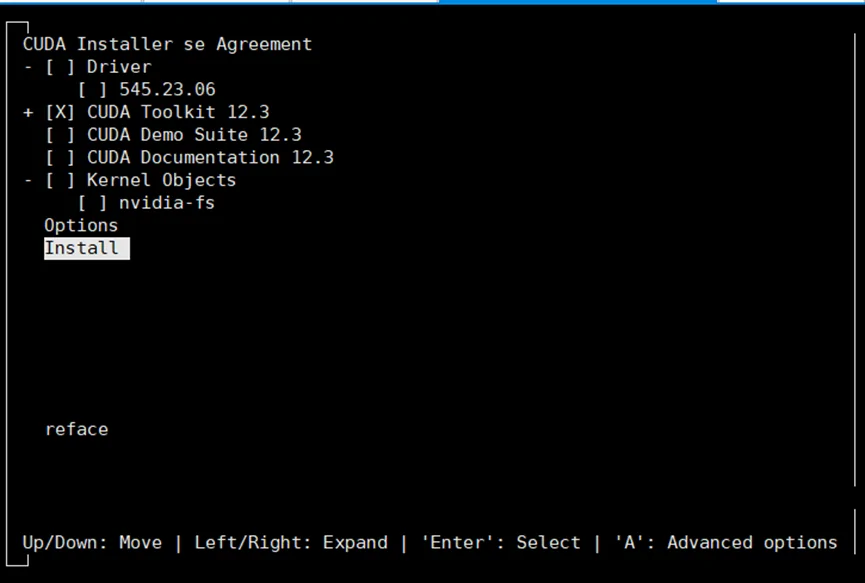

這個選項依空格只保留 cuda toolkit 12.3 然後 install 安裝。

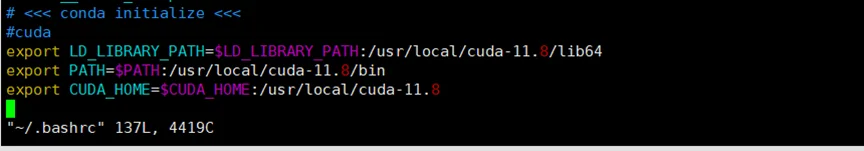

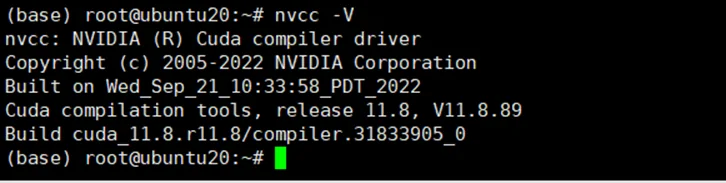

正常安裝完成後 linux 系統內是沒有 nvcc 命令的,建議透過編輯當前用戶的 ~/.bashrc 在最後一行添加下面字段,保存後 source ~/.bashrc 生效。

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda-11.8/lib64

export PATH=$PATH:/usr/local/cuda-11.8/bin

export CUDA_HOME=$CUDA_HOME:/usr/local/cuda-11.8

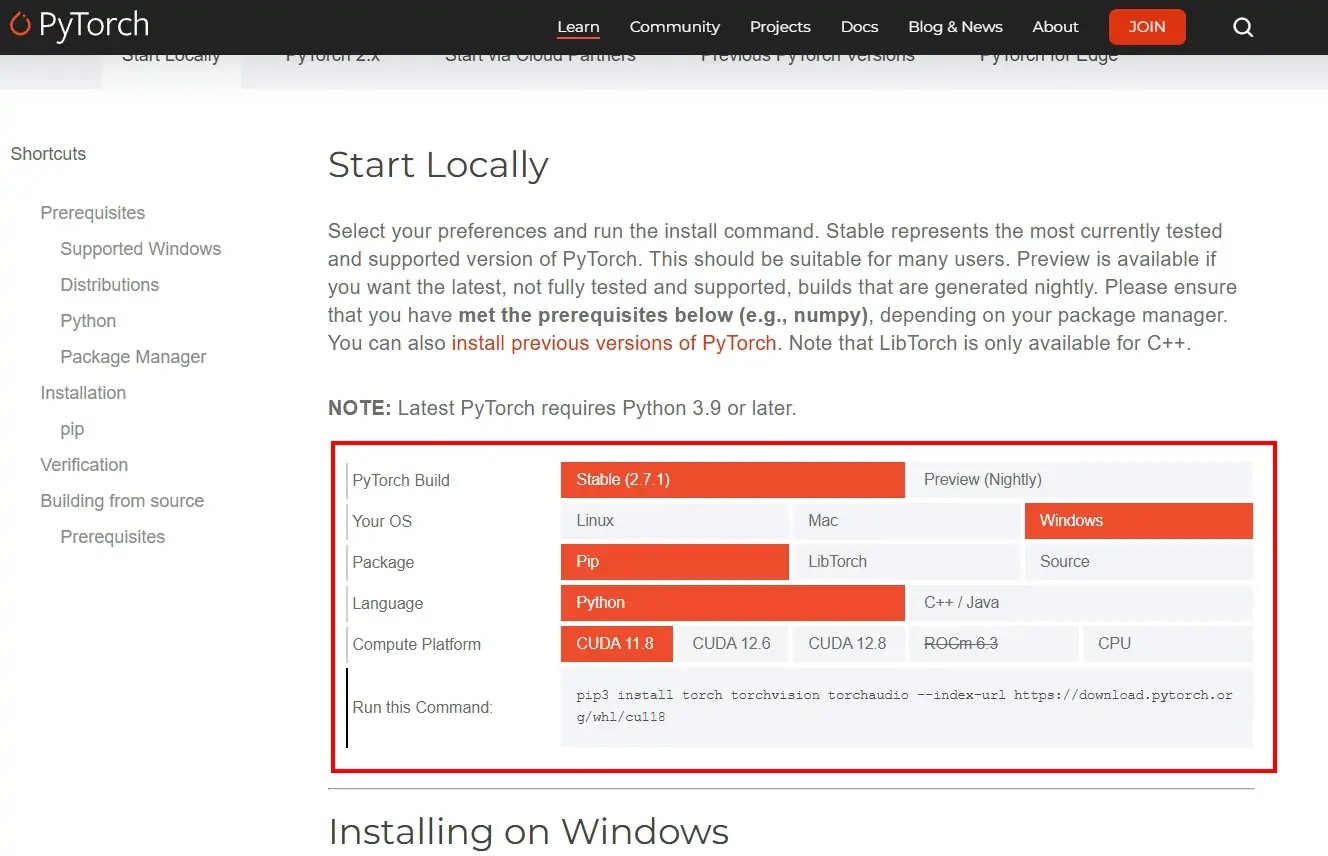

推薦官網安裝,選擇自己的安裝方式和 cuda 版本即可安裝:

其他版本安裝可在此連結找到

https://pytorch.org/get-started/previous-versions/

範例:安裝pytorch2.0.0,torchvision1.15.0,torchaudio2.0.0,cuda版本11.8

pip install torch==2.0.0 torchvision==0.15.0 torchaudio==2.0.0 –index-url https://download.pytorch.org/whl/cu118

順利安裝完可以用以下方式驗證

(base) root@ubuntu20:~# python

Python 3.9.7 (default, Sep 16 2021, 13:09:58)

[GCC 7.5.0] :: Anaconda, Inc. on linux

Type "help", "copyright", "credits" or "license" for more information.

>>> import torch

>>> print(torch.__version__)

2.0.0+cu118

使用 Conda 可快速建構虛擬環境與依賴控制,推薦於部署階段使用。

目前主流的 LLM 部署工具可分為兩大類型:

圖形介面工具(適合測試與互動操作)

Text Generation WebUI:支援多模型切換、LoRA/QLoRA、量化模型,可透過瀏覽器操作,是最多人使用的本地 GUI 部署介面。

LM Studio:跨平台桌面應用,適合入門者使用,快速執行模型互動。

API 部署工具(適合實務部署與服務串接)

vLLM:高效推論引擎,支援 FlashAttention、OpenAI API 格式,是企業部署首選。

TGI(Text Generation Inference):由 HuggingFace 開發,支援並發推論、FastAPI 架構與自動分片。

LMDeploy:由 Alibaba 提供,適合 INT4 / INT8 量化推論,適合中文 LLM 部署。

以下是主要 LLM 部署工具功能對照表,協助你根據需求選擇最適合的方式:

工具名稱 | 介面類型 | 支援模型格式 | 特點與優勢 | 適合對象 |

|---|---|---|---|---|

Text Generation WebUI | GUI | GGUF / HF Transformers | 多模型、LoRA、量化、插件豐富、操作簡單 | 測試、創作者、教育用途 |

LM Studio | GUI | GGUF / HF Transformers | 桌面應用、即開即用、跨平台支援 | 入門者、個人用戶 |

vLLM | API | HF Transformers | 高效推論、FlashAttention、OpenAI 相容格式 | 開發者、企業服務部署 |

TGI(Text Gen. Inference) | API | HF Transformers | FastAPI 架構、自動分片、多實例支援 | 中大型部署與並發需求 |

LMDeploy | API | INT4 / INT8 量化格式 | 支援低精度部署、中文模型優化 | 中文環境、節能推論需求 |

pip install huggingface_hub

huggingface-cli login

huggingface-cli download lmsys/vicuna-13b-v1.5

模型會以 safetensors 格式儲存,並放在 ~/.cache/huggingface/

pip install vllm

python3 -m vllm.entrypoints.openai.api_server \

--model lmsys/vicuna-13b-v1.5 \

--dtype float16 \

--port 8000

vLLM 啟動後會自動在指定埠口(預設為 8000)提供一組相容 OpenAI API 的伺服器介面,具備 /v1/chat/completions 和 /v1/completions 兩條主要路由,模擬原生 OpenAI 的行為。這代表你可以無需修改原有應用程式邏輯,就能直接改為串接本地部署的模型,例如:

在 Python 中將

openai.api_base設為http://localhost:8000/v1將前端或 webhook 原本指向 OpenAI 的 token 與 endpoint 改為內部主機 IP

配合 FastAPI、Flask、Node.js 等框架的 OpenAI SDK 或 HTTP request 方式呼叫

這樣你就能輕鬆將本地 LLM 推論服務整合進網站、機器人平台或企業內部系統中。

以下是範例程式碼(Python)用於串接本地 vLLM API:

import openai

openai.api_key = "EMPTY" # 本地部署通常不需要驗證金鑰

openai.api_base = "http://localhost:8000/v1"

response = openai.ChatCompletion.create(

model="lmsys/vicuna-13b-v1.5",

messages=[

{"role": "user", "content": "幫我寫一段介紹台灣美食的短文"}

]

)

print(response.choices[0].message["content"])

你也可以將其包裝成前端 Web App(如 React + Next.js)或後端 API(如 FastAPI),實現更完整的對話應用。此外,建議使用 Nginx 作為前端 Proxy,設定 TLS 憑證與反向代理,提升服務安全性與擴展性。

如果你希望部署成容器化形式,可使用 Docker Compose 建立簡易部署架構,例如:

version: '3.9'

services:

vllm:

image: vllm/vllm:latest

command: >

python3 -m vllm.entrypoints.openai.api_server \

--model lmsys/vicuna-13b-v1.5 \

--port 8000 \

--dtype float16

ports:

- "8000:8000"

volumes:

- ./models:/root/.cache/huggingface

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

搭配 Docker Desktop、Portainer 或自建 NVIDIA Container Toolkit,即可實現彈性部署與資源限制管理,適合多模型或跨團隊應用場景。

部署完成後,你的 LLM 模型就像一個本地版的 ChatGPT,可依照前述的串接方式與 Docker 化流程,實際應用於多種場景。例如:

作為企業內部文件問答系統核心,搭配 FastAPI 作為前端 API 管理層

整合 RAG 架構,讓本地 LLM 結合 FAISS / Elasticsearch 回答私有知識查詢

串接至 LINE Bot、Discord Bot、Telegram 等平台,透過 vLLM 的 OpenAI 相容 API 提供即時互動

開發 AI 寫作助手、SEO 關鍵字生成器或內部自動化工具

此外,搭配 Docker Compose 與 Nginx 代理設定,還能實現多模型切換、自動化啟動與多埠路由管理。進一步結合 Gunicorn 或 Uvicorn 等 ASGI Server,便能將模型打包為穩定高併發的微服務,支援數十甚至上百名用戶並行互動。

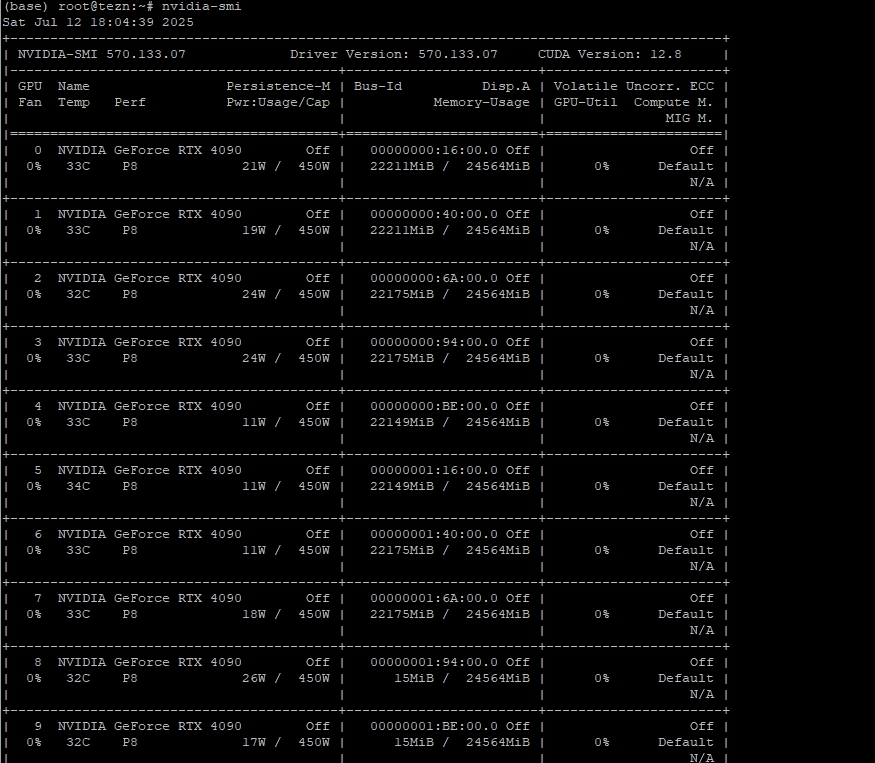

若有需要進一步進行 GPU 資源監控與模型健康管理,也可導入以下監控機制:

NVIDIA DCGM(Data Center GPU Manager):可即時監控 GPU 溫度、記憶體使用量、算力負載等關鍵指標,適合多卡環境。

Prometheus + Grafana:透過 exporter 套件收集 vLLM 或服務層的 API 呼叫次數、延遲、錯誤率等指標,並以圖表形式呈現。

NVIDIA SMI 指令結合 log 監控:搭配 cron job 或 log collection 工具監測 GPU 狀態、觸發自動告警或擴容。

透過上述工具,你可以打造出一套兼具效能、穩定性與可視化運維能力的 LLM 私有部署平台。

若想實現進一步的彈性與規模擴展,也可考慮以下進階策略:

容器自動擴縮(Auto Scaling):可使用 Kubernetes(K8s)或 Docker Swarm 管理 LLM 容器群,搭配資源監控觸發自動調整 GPU 資源。

模型快取與權重熱載入:使用 vLLM 提供的 lazy loading 或 memory-efficient loading 機制,動態載入需要的權重,節省 GPU 記憶體。

混合部署架構:將 RAG 的檢索層、LLM 推論層與前端服務層進行模組化分離,並依負載動態擴展,每層可獨立調整資源配置與更新策略。

這些進階策略將有助於企業級場景下的高可用、高效能 LLM 架構建置,提升部署彈性與營運效率。

若需部署於更大型或混合架構環境,也可考慮下列進階方案:

Kubernetes + GPU Operator:透過 K8s 管理 GPU container job,結合 NVIDIA GPU Operator 可自動設定 driver、DCGM、CUDA 環境與監控資源,適合多使用者或彈性任務排程場景。

模型快取與分佈式計算最佳化:針對大型模型,可採用 Tensor Parallel / Pipeline Parallel 設計,或利用 vLLM 的 lazy loading 與 FlashAttention 加速推論效率與記憶體使用。

整合 Triton Inference Server / KServe 架構:將推論服務封裝成 ONNX / TorchScript 模型,使用 Triton 或 KServe 提供彈性 endpoint、多模型熱切換、AB 測試等企業級佈署功能。

多模型併行與命名空間管理:建議將每個模型部署為獨立 Namespace(K8s)或獨立 GPU Pod,搭配 ingress controller 與負載均衡機制,可依負載自動調整服務數量,並記錄模型行為與統計。

這些元件與策略將有助於你打造一個能隨需求擴充、易於治理並具備觀測性(observability)的企業級 LLM 平台。

WebUI 側重圖形介面與支援多模型切換,適合開發測試與教學用途;vLLM 則效能最佳化、支援 FlashAttention 與 OpenAI API 格式,適合部署在伺服器環境、企業服務或 API 架構中。

是的。以 Vicuna-13B 或 LLaMA2-13B 為例,建議系統 RAM 至少 64GB,若執行多卡分佈式推論或大量並發請求,則建議配置 128GB 或更多,並使用高速 NVMe SSD 以支援快取與模型載入。

可以,只要在 Hugging Face 或 ModelScope 上下載中文 LLM 模型,例如 DeepSeek-VL、Baichuan2、Chinese-LLaMA2 等,部署步驟與英文模型相同,只需將 –model 參數改為對應模型 ID。

可以,推薦方式如下:

使用 Docker Compose 定義多服務,每個服務分配不同 GPU 或 port

使用 vLLM 搭配 FastAPI gateway 管理模型選擇

在 K8s 架構中以不同 namespace 或 deployment 隔離模型,並透過 ingress 實現路由分流

可搭配 DCGM/NVIDIA SMI 監控 GPU 負載,並整合 Prometheus + Grafana 或 Loki 進行統一日誌與指標視覺化。vLLM 亦可透過啟動指令設定 tracing 或調整 log level,以便偵錯與效能優化。

可使用 Kubernetes + GPU Operator 搭配 HPA/VPA(Horizontal/Vertical Pod Autoscaler)與 metrics server 實現自動擴縮,或配合 Prometheus 設定自動化觸發規則調整推論節點數量。

如果你希望獲得更快速、更穩定的模型部署體驗,歡迎洽詢 TAKI Cloud。我們提供從 GPU 主機挑選、驅動與環境建置、模型下載快取、自動化推論服務架設、API 串接與安全強化等一站式部署支援,讓你在短時間內即可擁有專屬的本地 AI 模型平台,無論是部署 LLaMA、DeepSeek-V2、Mistral 或多模型架構,我們都能提供技術顧問與實務解決方案,協助你快速上線、穩定營運。

RTX - 3090 GPU 主機

視頻渲染、科學模擬和機器學習

支援 DeepSeek-R1 32B

實例

8卡 NVIDIA RTX-4090 24G

數量

1

全台唯一提供高階 AI / GPU 主機租用

價格殺很大 / 量大可談

RTX - 4090 GPU 主機

視頻渲染、科學模擬和機器學習

支援 DeepSeek-R1 70B

實例

8卡 NVIDIA RTX-4090 24G

數量 庫存緊張,欲租從速

1

全台唯一提供高階 AI / GPU 主機租用

價格殺很大 / 量大可談

HGX H100 GPU 主機

視頻渲染、科學模擬和機器學習

支援 DeepSeek-R1 671B 滿血版

實例

8顆 NVIDIA HGX H100 80G

數量

1

全台唯一提供高階 AI / GPU 主機租用

價格殺很大 / 量大可談