目錄

GPU主機

GPU / AI 實體主機是專為人工智慧訓練與推論設計的高效能伺服器,核心特點在於能長時間穩定提供大量平行運算能力。

與一般 CPU 伺服器相比,GPU 實體主機特別適合用於深度學習模型訓練(Training)、大型語言模型(LLM)微調,以及高併發 AI 推論服務(Inference)。

當 AI 專案進入長期運作階段,例如每日固定訓練、企業內部模型、或資料無法上雲的情境時,GPU 實體主機通常在 成本可預測性、效能穩定度與資料控管 上,比雲端 GPU 更具優勢。

為什麼 GPU 實體主機是 AI 時代的必要裝備?

為什麼 AI 幾乎一定要用 GPU?CPU 不行嗎?

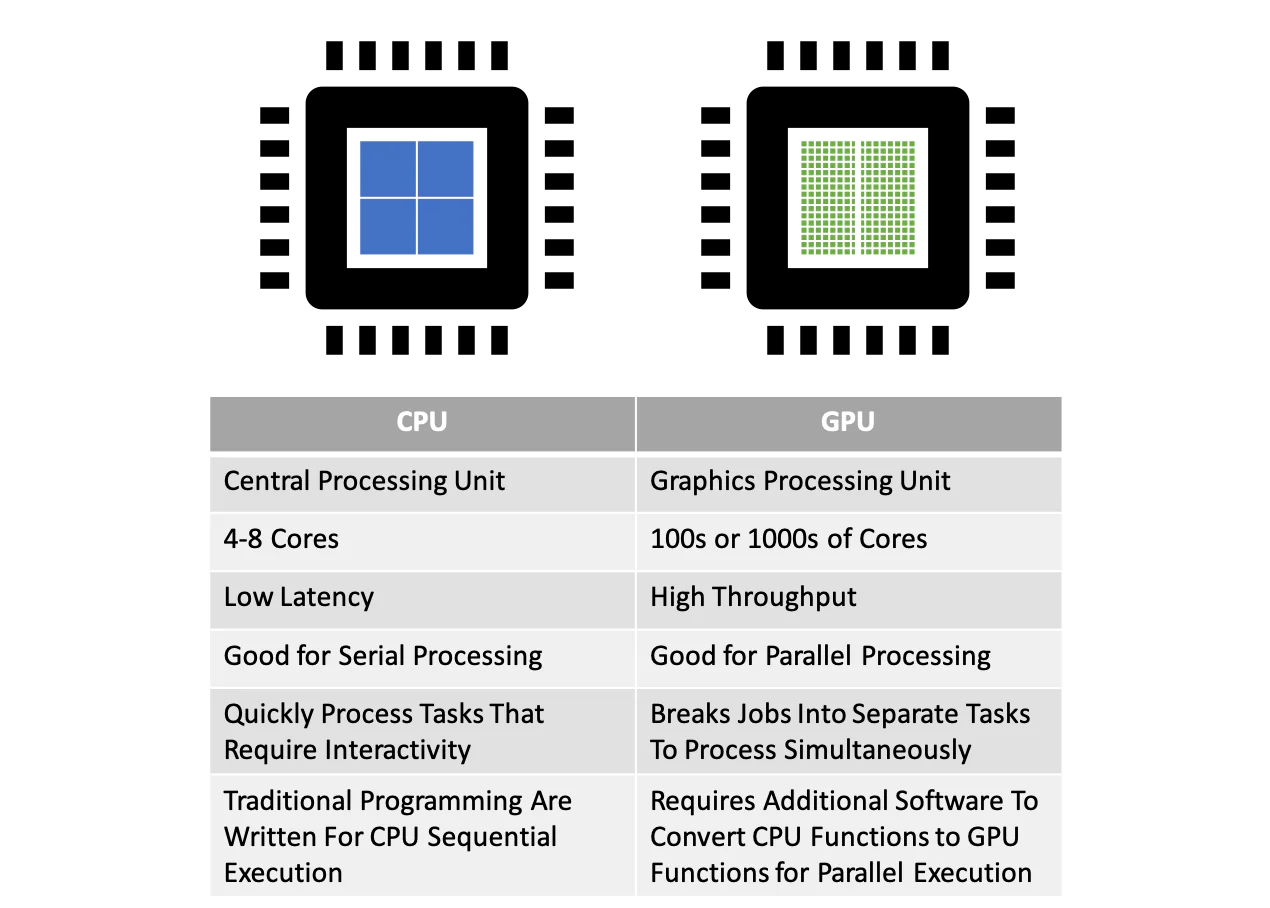

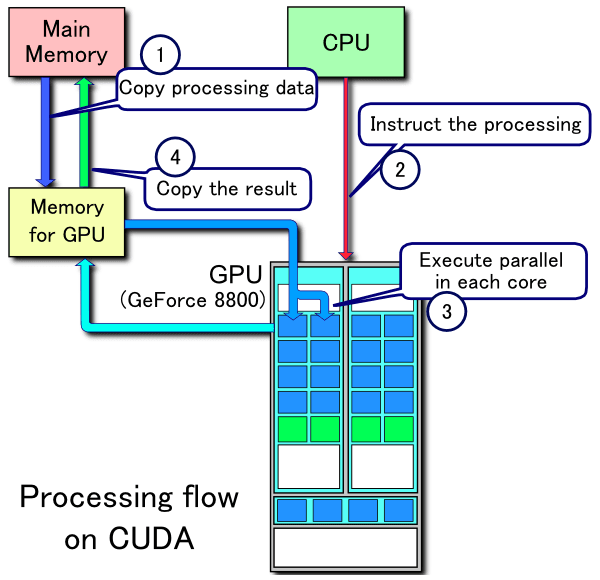

人工智慧與深度學習的核心運算,本質上是大量矩陣與向量的並行計算。

傳統 CPU 設計目標是處理少量、複雜且高度分支的指令流程,而 GPU 則天生就是為了「同時處理成千上萬筆數學運算」而設計。

在神經網路訓練過程中,例如卷積運算(Convolution)、矩陣乘法(Matrix Multiplication)、反向傳播(Backpropagation),幾乎都能被高度平行化。GPU 透過大量 CUDA Core 與 Tensor Core,可在單一時脈內完成遠超 CPU 的浮點運算量,這也是 GPU 能將 AI 訓練時間從「數週縮短為數天」的關鍵原因。

換句話說,不是 GPU 比 CPU 快一點,而是運算模型本身就為 GPU 而生。

AI 訓練(Training)與推論(Inference)對主機需求的關鍵差異

許多人在規劃 AI 硬體時,最大的誤解就是「所有 AI 都需要同一種 GPU 主機」。

實際上,AI 訓練與 AI 推論的硬體需求差異極大。

AI 訓練(Training)重點需求

大量 GPU 記憶體(VRAM),用來容納模型權重與 batch 資料

高記憶體頻寬,避免資料等待造成 GPU 閒置

能長時間 100% 穩定滿載運作

AI 推論(Inference)重點需求

低延遲回應時間

高併發處理能力

可水平擴充的部署架構

因此,一個只做模型推論的服務,未必需要頂級訓練型 GPU;

但任何要進行模型訓練、微調(Fine-tuning)的專案,幾乎都無法脫離 GPU。

到底什麼是 GPU 實體主機?

GPU 實體主機 就是配備了高階顯示卡(也就是 GPU)的獨立主機。這些主機不是拿來打電動,而是拿來跑 AI 模型、深度學習、視覺辨識或做資料分析用的。

GPU主機和一般主機有什麼差別?

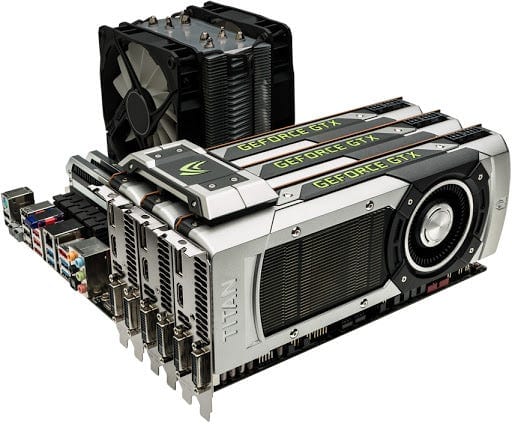

傳統主機靠 CPU 運作,而 GPU主機 除了 CPU,還搭載了 NVIDIA 的 RTX 或 A100、H100 等強力 GPU,可以同時處理大量數據,是跑 AI 模型的首選。

GPU主機常見硬體規格會有哪些?

高效能 CPU(Intel Xeon 或 AMD EPYC)

一張甚至多張 RTX 4090 或 A100 顯示卡

至少 64GB 的 ECC 記憶體(防止運算錯誤)

NVMe SSD 快速儲存 + RAID 備援

10Gbps 高速網路

常見 GPU 型號適合哪些 AI 工作負載?

選 GPU 不能只看「效能最高」,而是要看「適不適合你的 AI 任務」。

GPU 類型 | 適合情境 |

|---|---|

RTX 4090 / 5090 | 個人或團隊研發、LLM 微調、Stable Diffusion、AI 開發測試 |

RTX 5880(多卡) | 中大型模型訓練、企業內部 AI 平台 |

A100 / H100 | 超大型模型、長時間訓練、24/7 生產級 AI 服務 |

實務上,多數 AI 專案並不需要一開始就使用 A100 或 H100,而是會在模型成熟後才升級硬體。這也是為什麼可客製化的 GPU 實體主機,會比固定規格的雲端方案更具彈性。

為什麼越來越多 AI 專案選擇 GPU 實體主機,而不是雲端?

雲端 GPU 的優點是啟用快速、彈性高,但當 AI 專案進入實際運作階段後,常會遇到以下問題:

長時間訓練導致成本快速累積

GPU 規格、I/O、網路拓撲不可控

資料與模型需上傳雲端,涉及資安與合規風險

相對而言,GPU 實體主機能讓團隊完整掌握硬體效能、資料流向與成本結構。

當 AI 專案進入長期訓練、內部模型或企業級部署階段時,實體主機通常更可控、也更省。

GPU / AI 實體主機適合哪些族群?

AI / 機器學習工程師(研發、實驗、模型微調)

典型需求特徵

- 需要反覆訓練、測試、比較模型(多版本、多參數)

- 進行 LLM 微調(LoRA / QLoRA / SFT)

- 需要穩定 CUDA / Driver / PyTorch 環境,不想每次雲端重建

- 長時間跑 Stable Diffusion、影像生成或 embedding 建立

常見工作負載

- PyTorch / TensorFlow 訓練

- LLM 微調、CV 訓練、AIGC 生成

- Triton / vLLM / TensorRT 推論測試

建議硬體配置(實務導向)

- GPU:RTX 4090 / 5090(高 CP 值研發首選)

- CPU:高 PCIe Lane(避免 GPU 吃不滿頻寬)

- 記憶體:128GB 起跳(多實驗同時跑)

- 儲存:NVMe SSD(模型與資料集 I/O 不能慢)

顧問式提醒:

很多效能瓶頸不是 GPU 不夠快,而是 資料進不來

新創團隊 / 產品型公司(AI 要變成服務)

典型需求特徵

- AI 不是 demo,而是要提供 穩定 API / 內部服務

- 需要預測每月成本,不希望雲端 GPU 用量失控

- 同一套硬體要兼顧:訓練、測試、推論

常見工作負載

- LLM 推論 API(客服、摘要、分類)

- OCR / 影像辨識服務

- 私有 RAG(embedding + 向量資料庫)

建議架構思維

- 推論(線上)與訓練(離線)分離

- GPU 實體主機跑核心推論

- 非即時任務排程化,避免資源互搶

顧問式提醒:

產品化 AI 的關鍵不是「跑多快」,而是 穩定度 + 延遲一致性。

企業內部 AI / 私有部署(資料敏感、合規)

典型需求特徵

- 資料無法上雲(內部文件、客戶資料、合約、醫療 / 金融)

- 需要內網部署,整合 AD / 權限控管 / 稽核

- 模型需長期更新、持續運作

常見工作負載

- 企業內部知識庫 RAG

- 私有 LLM / Copilot

- 品檢、製造數據分析、內部決策模型

建議重點

- 穩定性與可維護性 > 峰值效能

- 預留擴充空間(GPU / 記憶體 / NVMe / 網路)

- 完整監控與備援思維

顧問式提醒:

企業 AI 成功的關鍵不是模型多大,而是 能否長期穩定運作。

內容製作 / 影像影音 / AIGC 團隊

典型需求特徵

- 每天大量產圖、影片處理、批次生成

- 不希望排隊、不想被平台限流

- 素材與模型需本地保存(版權 / 商業機密)

常見工作負載

- Stable Diffusion / ComfyUI

- 影片去噪、補幀、超解析

建議配置觀念

- VRAM 比算力更重要(高解析度生成)

- NVMe I/O 會直接影響批次速度

工程模擬 / 科學運算 / HPC

典型需求特徵

- CUDA 加速模擬(CFD、電磁、結構分析)

- 長時間滿載、對穩定度極度敏感

關鍵考量

- CPU 核心數與記憶體容量

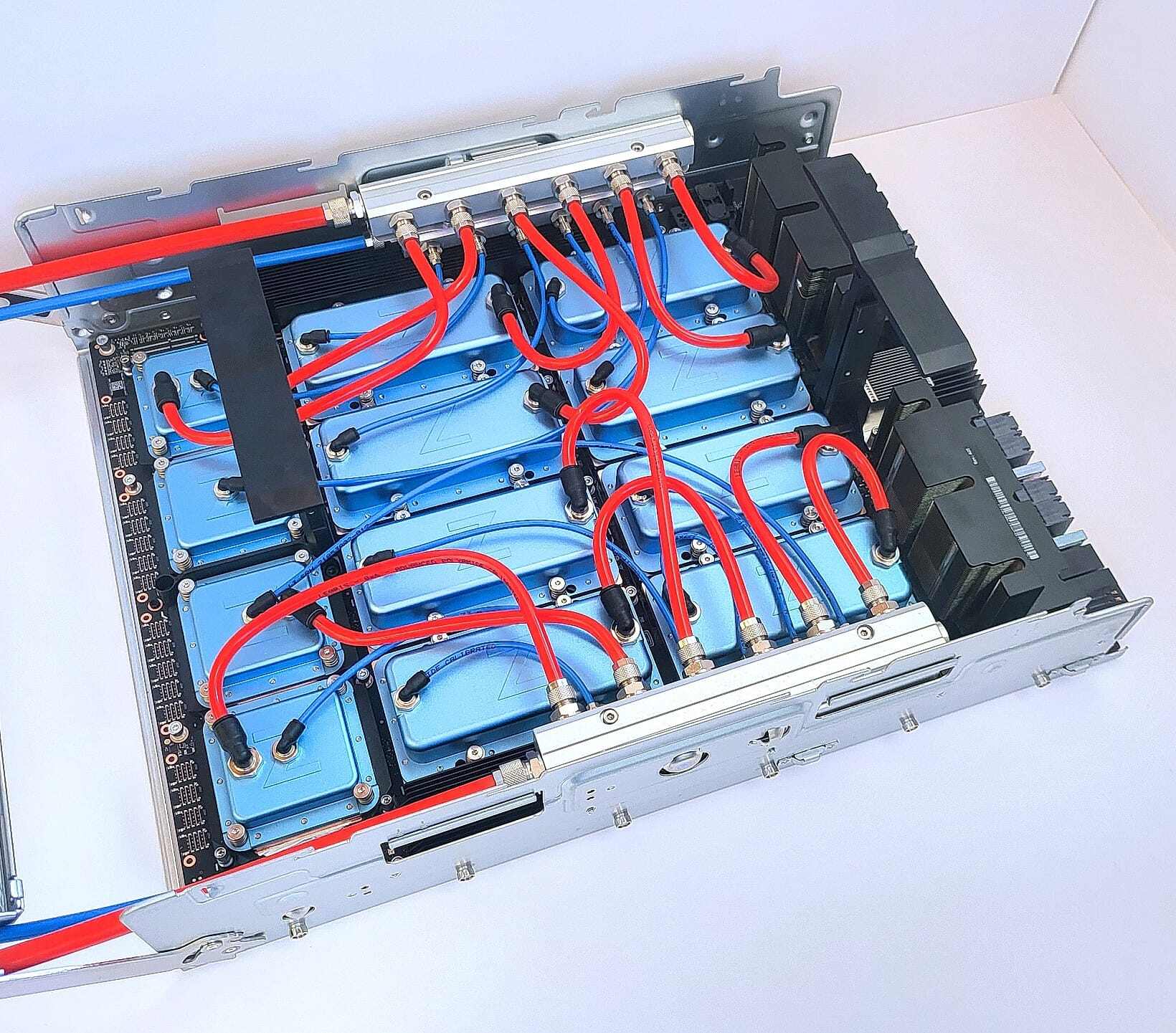

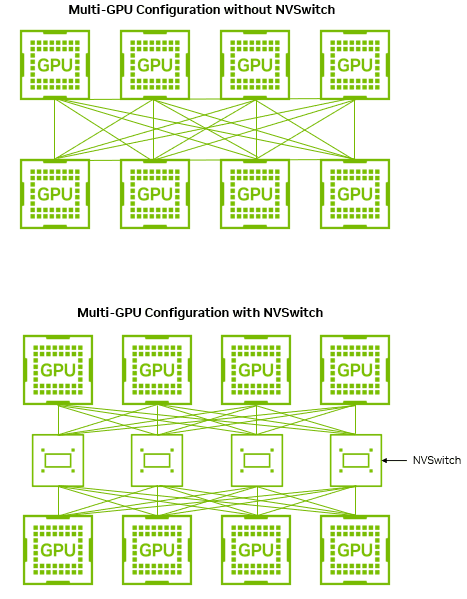

- PCIe / NUMA / 多卡拓撲

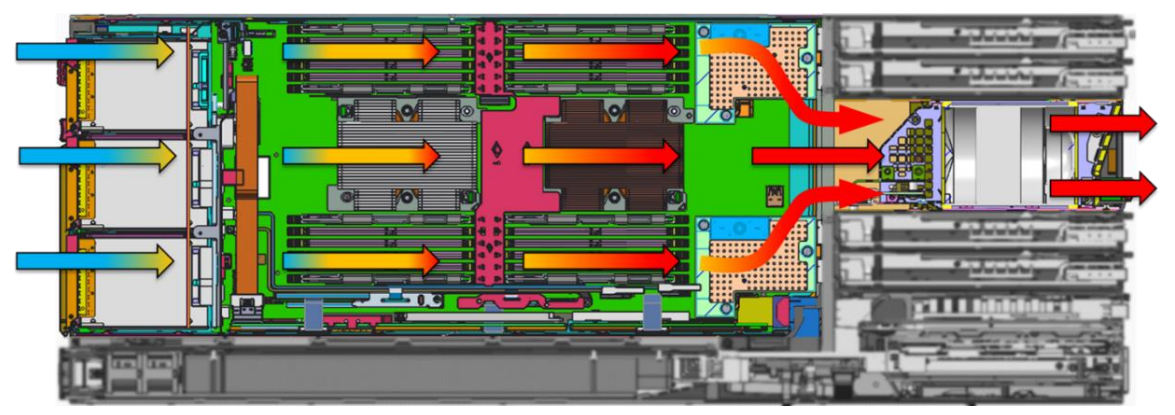

- 散熱與電力設計

哪些時候你需要 GPU主機?

一台真正適合 AI 的 GPU 實體主機,不能只看 GPU

GPU 很重要,但不是唯一關鍵。實務上,AI 效能瓶頸常出現在:

CPU PCIe 通道數不足,導致 GPU 吃不到完整頻寬

記憶體頻寬與 NUMA 架構不佳

NVMe I/O 吞吐不足,資料餵不進 GPU

散熱與電力設計不良,長時間降頻

這也是為什麼「把一張 GPU 插進桌機」與「專為 AI 設計的 GPU 實體主機」,在穩定度與效能上會有本質差異。

怎麼取得或使用 GPU主機?

其實要用上 GPU主機 不難,有幾種方式可以選:

常見方式:

- 自己買一台 GPU主機,搬回公司使用(缺點是成本高、維運麻煩)

- 租用現成的 GPU主機服務,像是 TAKI Cloud 提供的 RTX 4090 GPU 主機

- 若你是企業,也可以建自己的小型 AI 資料中心

GPU主機 常見問答 FAQ

GPU主機 多了強大的顯示卡,能同時處理大量資料,非常適合做 AI 訓練和影像處理。

只要有長時間 AI 運算需求(如模型訓練、影像生成),實體主機通常比雲端更划算。

看你模型大小。小一點的模型用 RTX 4090 就夠了,大模型(像 70B 參數以上)就得靠 A100 或 H100 這種專業卡。

大部分情況是一樣的,AI 主機通常就是指內建 GPU、且已經為 AI 運算優化的主機。

可透過多卡架構、模型切分或多機叢集方式擴充,實體主機在這方面彈性最高。

目前主流深度學習框架仍高度依賴 CUDA 生態,NVIDIA 仍是最成熟選擇。

台灣的 TAKI Cloud 就提供多張 GPU主機 的租用方案,價格合理、彈性高,非常適合新創團隊與研究單位。

如果你準備踏入 AI 的世界,或是想加速模型訓練、處理龐大數據,那 GPU主機 會是你最佳的硬體投資!

關於 TAKI Cloud

TAKI Cloud 提供專業的 AI 伺服器租用、GPU 雲端運算並專注於AI伺服器與GPU雲端服務,提供符合國際標準的中華電信 IDC 機房與 24 小時技術支援,協助國內外 AI 團隊快速布署最新大模型,具備多年 A100 / H100 環境管理與支援經驗。

官方網站:www.taki.com.tw

RTX - 3090 GPU 主機

視頻渲染、科學模擬和機器學習

支援 DeepSeek-R1 32B

實例

8卡 NVIDIA RTX-4090 24G

數量

1

全台唯一提供高階 AI / GPU 主機租用

價格殺很大 / 量大可談

RTX - 4090 GPU 主機

視頻渲染、科學模擬和機器學習

支援 DeepSeek-R1 70B

實例

8卡 NVIDIA RTX-4090 24G

數量 庫存緊張,欲租從速

1

全台唯一提供高階 AI / GPU 主機租用

價格殺很大 / 量大可談

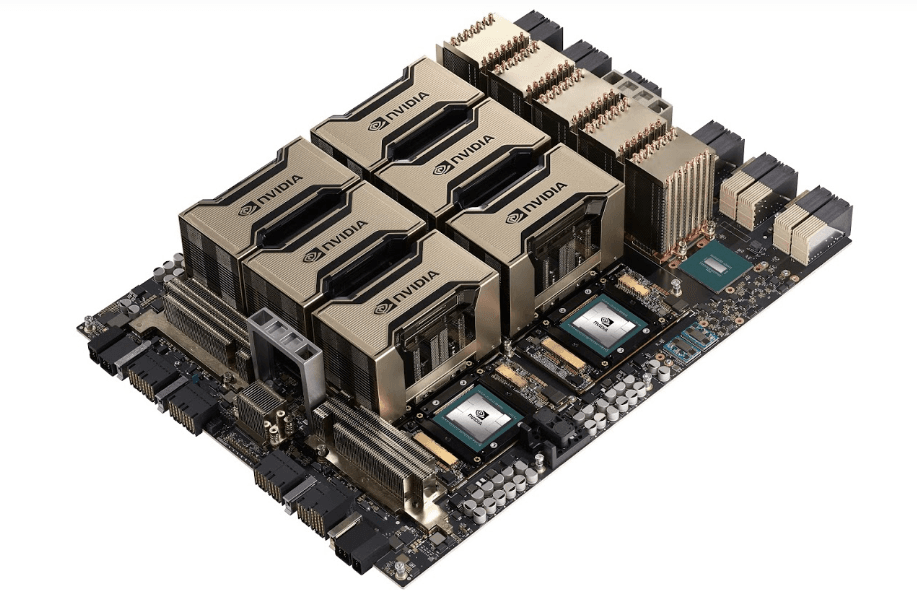

HGX H100 GPU 主機

視頻渲染、科學模擬和機器學習

支援 DeepSeek-R1 671B 滿血版

實例

8顆 NVIDIA HGX H100 80G

數量

1

全台唯一提供高階 AI / GPU 主機租用

價格殺很大 / 量大可談