目錄

過去十多年,網站流量主要來自搜尋排名。只要 SEO 做得好、關鍵字排得前,網站就能獲得穩定點擊。

在 AI 搜尋逐漸取代傳統搜尋結果頁的時代,網站是否能被「引用」、而不只是被「排名」,已成為關鍵差異。

AI 系統在產生答案時,會實際存取網站內容、評估回應速度、穩定性與技術可信度,而 WordPress 主機正是這一切的基礎層。

如果主機效能不穩、回應延遲或頻繁錯誤,即使內容再好,也可能無法進入 AI 搜尋的引用來源名單。

這也是為什麼,WordPress 主機在 AI 搜尋時代,從「後台設備」轉變為影響流量、品牌曝光與專業信任度的核心關鍵 , AI 搜尋的出現,正在改變這個規則。。

AI 搜尋如何重新定義「流量來源」?

過去我們把「流量來源」理解成:使用者在 Google 搜尋 → 點擊藍色連結 → 進站(GA4 記成 Organic Search)。

但 AI 搜尋(例如 Google AI Overviews、Bing Copilot、Perplexity 等)正在把這條路徑改成「答案先行」,導致流量來源被重新分配,甚至「被引用」卻「沒有點擊」。

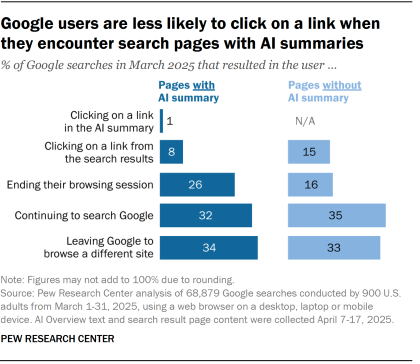

右邊圖示根據 Pew Research Center 2025 年的實測數據,當搜尋結果出現 AI Summary 時,使用者點擊網站連結的比例幾乎減半,顯示 AI 搜尋已實際重塑流量分配模式。

最重要的三個數據(核心解讀)

1️⃣ 點擊網站連結的比例「大幅下降」

行為 | 有 AI Summary | 沒有 AI Summary |

|---|---|---|

點擊 AI Summary 裡的連結 | 1% | N/A |

點擊搜尋結果中的網站連結 | 8% | 15% |

重點一句話:

有 AI Summary 時,使用者點網站的機率幾乎「砍半」。

這直接證實一件事:

AI 搜尋正在吃掉傳統 SEO 的點擊空間。

2️⃣ 使用者「直接結束瀏覽」的比例上升

行為 | 有 AI Summary | 沒有 AI Summary |

|---|---|---|

結束瀏覽(不再點任何東西) | 26% | 16% |

代表什麼?

很多使用者「只看 AI 摘要就走了」,根本不需要點進任何網站。

3️⃣ 使用者「繼續搜尋 Google」的比例下降

行為 | 有 AI Summary | 沒有 AI Summary |

|---|---|---|

繼續搜尋 | 32% | 35% |

離開 Google 去其他網站 | 34% | 33% |

AI Summary 縮短了搜尋路徑,讓使用者「更快得到答案 → 更快離場」。

1.從「點擊流量」變成「引用流量」與「零點擊流量」

AI 搜尋的核心變化是:使用者不一定需要點你的網站,也能得到完整答案。

Pew Research Center 針對 2025 年 3 月美國成人的 Google 行為研究顯示:

當搜尋結果出現 AI 摘要時,使用者點擊傳統自然搜尋結果的比例 降到 8%;沒有 AI 摘要時是 15%(幾乎差一倍)。(數據出處pewresearch.org)

使用者點擊 AI 摘要內「引用來源連結」 的比例更低,僅 1%。(數據出處pewresearch.org)

有 AI 摘要時,使用者「直接結束瀏覽階段」的比例也更高:26% vs 16%。(數據出處pewresearch.org)

這代表:同一個關鍵字,你可能「被 AI 引用」,但 GA4 不一定看得到「等比例的點擊進站」。你的品牌在被看見,但不是以你熟悉的流量形式發生。

2.流量來源結構會出現「被切走」與「被改寫」

AI 搜尋會把一部分原本屬於 Organic Search 的需求,改寫成下列幾種「新型來源」:

SERP 內消化(零點擊):使用者在 AI 摘要就完成決策,網站不再被點擊(你只剩曝光、而非會話)。

引用導流(Citation-driven traffic):少量使用者會沿著 AI 的引用連結進站,但這類流量通常更「目的明確」,也更容易直接看方案/比較/FAQ(屬於高意圖)。

二跳導流(Second-hop traffic):AI 摘要會把使用者導向 Wikipedia、Reddit、YouTube 等聚合平台,再由平台導向你(你在 GA4 看到的可能是 Referral,而非 Organic)。Pew 的研究也指出 AI 摘要與標準結果最常引用的來源包含 Wikipedia、YouTube、Reddit。

換句話說:「流量來源」不再只是一個 channel 分類問題,而是使用者決策路徑被重組。

3.對企業最直接的影響:你會看到「自然搜尋流量不一定成長,但成交更可能成長」

AI 搜尋把大量低意圖、資訊型查詢攔在 SERP 上;留下來的點擊更偏向:

需要方案細節、價格、規格

需要可信度背書(案例、SLA、技術架構)

需要立即行動(詢價、聯繫、下單)

因此你在 GA4 上可能會遇到一個新常態:

Organic Search Sessions 不一定增加

但 來自 AI/引用的會話,平均參與度、轉換率可能更高

你的 KPI 必須從「流量量」逐步升級成「可被引用 + 可被驗證 + 可轉換」

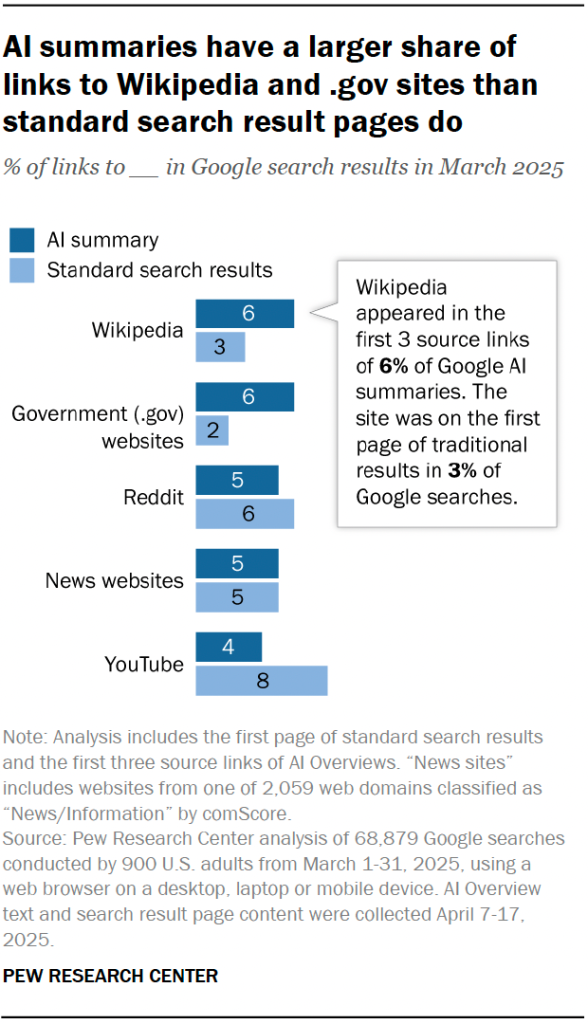

根據 Pew Research Center 於 2025 年的研究,Google AI 搜尋摘要明顯偏好引用 Wikipedia、政府網站與新聞來源。這些網站的共同特點並非行銷能力,而是長期穩定性、結構一致性與高度可驗證性。這代表 AI 搜尋正在將「可信技術基礎」視為引用的核心條件,而非單純的搜尋排名。

關鍵結論(重點數據解讀)

1️⃣ Wikipedia 與 .gov 在 AI 搜尋中的佔比「直接翻倍」

來源 | 有 AI Summary | 傳統搜尋 |

|---|---|---|

Wikipedia | 6% | 3% |

政府網站 (.gov) | 6% | 2% |

AI 搜尋引用 Wikipedia / .gov 的比例,是傳統搜尋的 2~3 倍

圖中右側也特別標註:

Wikipedia 出現在 6% 的 AI 摘要前三個來源連結中,

但在傳統搜尋結果首頁只佔 3%。

以下是為了能夠滿足段落所需的長度而定義的無意義內文,請自行參酌編排。

2️⃣ Reddit、新聞站:不是「內容多」,而是「可信」

來源 | 有 AI Summary | 傳統搜尋 |

|---|---|---|

Reddit | 5% | 6% |

News websites | 5% | 5% |

Reddit 與新聞站 沒有被降權,但它們被視為「可佐證、可交叉驗證」的來源。

3️⃣ YouTube 在 AI 搜尋中反而被「明顯弱化」

來源 | 有 AI Summary | 傳統搜尋 |

|---|---|---|

YouTube | 4% | 8% |

AI 摘要不愛影片,因為影片 不利即時驗證、引用與語意拆解。

為什麼 AI 會「實際存取」你的網站?

這正是多數企業忽略、卻最致命的一環

很多人以為「AI 搜尋只是把別人的內容摘要一下」,所以只要文章寫得好就會被引用;但在 Google 的 AI Overviews / AI Mode 等 AI 搜尋體驗裡,AI 要能引用你的網站,前提是 Google 的系統必須能找到、抓取、理解、並信任你的頁面。這個流程本質上仍然屬於 搜尋引擎的 crawling / indexing / serving,只是呈現方式從「10 個藍色連結」變成「AI 先回答 + 附上來源」。Google for Developers+1

結論是在 Google AI Overviews、AI Mode 等 AI 搜尋機制中,內容只是門票,真正決定能否被引用的,是網站本身是否「值得被存取與信任」。

AI 搜尋並不是憑空產生答案,而是建立在搜尋引擎既有的抓取、索引與即時存取架構之上。當 AI 在生成摘要時,它會實際向來源網站發出請求、讀取內容、驗證穩定性,最後才決定是否將該網站列為引用來源。

這意味著一件事:

如果你的網站在「被存取的當下」表現不穩定,就算內容再好,也可能直接被排除在 AI 搜尋之外。

AI 搜尋對網站的實際要求,比你想像得更嚴格

在 AI 搜尋流程中,網站至少必須同時通過以下四個關卡,而這些關卡幾乎全部與主機與架構直接相關。

1.能不能被穩定抓取(Availability)

AI 與搜尋系統會頻繁向網站發送請求。

若網站出現以下情況,引用機率會快速下降:

回應過慢、間歇性 timeout

出現 403、429、5xx 錯誤

因共享主機資源爭用而被誤判為「不可靠來源」

對 AI 而言,不穩定=不可信。

2. 回應是否一致(Consistency)

AI 不只看內容,還會觀察「同一個 URL 在不同時間是否給出一致回應」。

有時快、有時慢

有時能抓、有時被擋

不同 user-agent 回傳不同頁面結構

這類情況在資源未隔離、快取策略混亂的主機上極為常見,而結果只有一個:

AI 系統無法建立長期信任。

3.「內容是否容易被理解與引用(Extractability)

AI 需要的不只是「存在的內容」,而是:

結構清楚的 H1 / H2 / H3

穩定可渲染的 HTML

不依賴登入、不被 JavaScript 隱藏的核心資訊

如果主機效能不足,導致頁面渲染延遲或載入不完整,AI 在解析階段就可能直接放棄。

4. 是否能成為「可信支援來源」(Trust Signal)

根據研究,AI 搜尋明顯更偏好引用 穩定、權威、技術品質高的網站。

這也是為什麼政府網站、維基百科、大型資訊平台在 AI 搜尋中佔比明顯提高。

換句話說,主機穩定性已成為一種「技術信任訊號」。

WordPress 主機在 AI 搜尋中扮演什麼角色?

在 AI 搜尋(Google AI Overviews、Gemini、Perplexity、Copilot 等)裡,WordPress 主機不只是「放網站的地方」,而是 AI 是否能穩定存取、正確理解並願意引用你內容的底層條件。

你可以把它理解成:內容是「要被引用的答案」,主機是「答案是否能被可信地取用」。

AI 搜尋對網站的評估,通常會落在三個層級:可存取性、可理解性、可信一致性,而這三個層級都會被主機/架構直接影響。

1.可存取性:AI 能不能順利「抓到」你的內容

AI 產生摘要時,常見行為包含:

模型/系統對候選來源做抓取(或經由搜尋引擎既有抓取系統存取)

在短時間內發出多次請求(不同 user-agent、不同地區節點、不同時間點)

遇到錯誤時會改選替代來源(因為它必須交付答案)

所以主機若出現任何「不穩定」,會直接降低成為引用來源的機率,例如:

5xx(PHP/LiteSpeed/MariaDB 壓力造成)

429/403(WAF/Rate limit 誤擋,或 bot 設定過嚴)

Timeout / 高延遲(TTFB 波動大)

瞬間高峰被打爆(共享資源爭用、LVE 限制、EP/NPROC/Mem 觸頂)

結論:AI 不會等你修好;它會直接引用下一個更穩定的來源。

2.可理解性:AI 能不能「解析出」你要傳達的重點

很多網站內容「人看得到」,但 AI 解析不一定順利,常見原因是:

- HTML 結構混亂、H1/H2 不清楚

- 內容過度依賴 JS 才會出現(或延遲渲染)

- 快取策略不一致,導致同一 URL 取到不同版本(尤其有 Cloudflare/頁面快取/外掛快取混用時)

- WordPress 輸出被壓縮/合併/延遲載入搞到 DOM 結構破碎

主機扮演的角色是:讓「同一篇內容」以一致、可預期、完整的 HTML 形式穩定輸出。

當你能做到「一致輸出」,AI 才能更容易抽取:

- 定義(是什麼)

- 條件(適用什麼情境)

- 步驟(怎麼做)

- 證據(為什麼可信)

3.可信一致性:AI 會偏好「穩定、權威、可驗證」的來源

你貼的 Pew 圖其實點出一個非常重要的訊號:

AI 摘要的引用更傾向 Wikipedia、.gov 等權威來源,代表 AI 系統在挑引用來源時,會偏好:

- 容錯率低(很少壞、很少不通)

- 回應穩定(TTFB、錯誤率低)

- 內容結構一致(可抽取、可引用)

- 能長期被驗證(同一 URL 長期有效)

主機會影響這些訊號的「技術面」:

即使你不是 .gov 或 Wikipedia,你也能透過 穩定性 + 一致性 + 安全性,讓 AI 更願意把你當成「可信來源」。

具體來說:主機會影響哪些「AI Search 關鍵指標」?

以下是你可以在頁面上用的「指標化」描述(更企業級):

A. TTFB(Time To First Byte)

- AI/爬蟲存取時,TTFB 波動越小越好

- 共享資源爭用最常造成「一下快一下慢」的波動

B. 錯誤率(5xx/429/403)

- AI 摘要引用需要高度穩定

- 一旦常見 5xx/429,會被快速降權或轉向替代來源

C. 一致回應(Cache/Variant Consistency)

- 同一 URL 對不同 user-agent/不同節點輸出一致

- 快取混用(CF + LiteSpeed + 外掛)容易造成版本漂移

D. 安全與可用性(WAF/Rate Limit 不誤傷)

- 擋攻擊要擋得準

- 但不能把 AI/搜尋引擎當成攻擊擋掉(這很常見)

一般共享型虛擬主機的隱性風險

一般共享型(Shared Hosting)主機的核心邏輯是「多人共用同一台伺服器、同一組資源池」,即使有做基本隔離,效能與穩定性仍會受到其他租戶行為影響。在傳統 SEO 時代,這可能只是「偶爾慢一點」;但在 AI 搜尋時代,它更容易演變成「可信度下降、引用機率降低、品牌曝光變少」的結構性風險。

下面把共享型主機最常被忽略的隱性風險拆解成可檢核的面向。

1. 資源爭用導致「回應不一致」:AI/搜尋引擎最不喜歡的狀態

共享主機的最大問題不是「永遠很慢」,而是「一下快一下慢」。

原因通常是同機租戶的尖峰行為(批次任務、備份、爬蟲、流量暴增、程式錯誤造成高 CPU/RAM、MySQL 慢查詢等)會把整台機器的 I/O、CPU、RAM 拉爆,讓你網站的 TTFB、完成時間、錯誤率產生波動。

對 AI 搜尋而言,這是致命的:

- 同一個 URL 不同時間抓取,回應速度差很多

- 抓取剛好落在尖峰,容易 timeout 或 5xx

- 系統會傾向改引用「更穩定」的來源(因為它要交付答案)

共享主機的風險,本質是「穩定性不可控」。

2. LVE/EP/NPROC 等限制造成「看似正常、實際被掐住」

多數共享主機會用 CloudLinux LVE 類型的限制來分配資源(你目前也在用)。

這能避免單一租戶把整台機器吃垮,但副作用是:你在尖峰時會被自己的限制卡住。

常見現象:

- EP(Entry Processes)觸頂:同時間進來的 PHP 請求被排隊/拒絕,使用者看到慢或 503

- PMEM/VMEM 限制:PHP(例如 lsphp)被記憶體 cgroup OOM kill(你前面 dmesg 就出現過)

- NPROC 限制:高併發時 PHP/後台工作排程無法正常啟動

- IO/IOPS 限制:大量圖片、快取重建、WooCommerce 查詢等更容易被拖慢

重點是:

這些限制在平常流量下可能都看不出來,一旦遇到「AI/搜尋高頻抓取、社群爆量、行銷活動」就會突然觸發,造成錯誤率上升,進一步影響 AI 對網站的引用信任。

3. I/O 與資料庫爭用:WordPress 最常爆的點

WordPress 的效能瓶頸通常不是 PHP,而是:

- MySQL/MariaDB 的慢查詢、鎖、暫存不足

- 磁碟 I/O 爭用(共享主機最常發生)

- 大量圖片/縮圖生成、外掛寫入、快取寫入

共享主機上,同一台機器的 MySQL 與磁碟 I/O 常常是被多人共用。你就算把單站的 cache 做滿,如果底層 I/O 被別人拖慢,會出現:

- 後台卡頓

- 前台偶發慢

- 尖峰時 502/504/500

- Cron / wp-cron 堆積,造成更大的延遲雪崩

這類問題在 AI 搜尋時代的風險是:

AI/爬蟲抓取往往是「多次、分散、持續」的,當你網站回應不穩,就更容易被排除出引用來源。

4.快取策略與輸出版本漂移:同頁面對不同請求輸出不同內容

共享主機為了撐多站,通常會堆很多層:

Cloudflare/CDN 快取

LiteSpeed Cache / Nginx FastCGI cache

WordPress 外掛快取

Object Cache(Redis/Memcached)

如果沒有把「可變因子」規則訂好(Cookie、User-Agent、Query string、登入狀態),很容易發生:

- 同一 URL 對不同 UA 產生不同 HTML

- 同一頁面有時候是新、有時候是舊(cache 穿透/不一致)

- AI 抓到的版本剛好缺段落、或結構不完整

AI 要引用內容時,最需要的是「穩定、可預期、可重現」的輸出。

共享主機常常為了省資源,把快取設得很 aggressive,但沒有做一致性治理,反而會讓 AI 判讀變差。

5.安全與防護誤傷:把 AI/搜尋引擎當成攻擊擋掉

共享主機常見做法是用 WAF / 防火牆規則保護整台機器,但會遇到兩個問題:

- 規則是「全機共用」,容易誤擋正常流量

- 為了擋爆量,常設很嚴格的 rate limit,結果把爬蟲/AI 存取擋掉

你會看到的症狀是:

- 403/429 增加

- Googlebot 或其他 crawler 偶發抓不到

- AI 來源平台的訪問不穩

在 AI 搜尋的世界,這不只是少一些 crawl;而是「你不在引用候選名單」。

共享主機的風險,為什麼在 AI 搜尋時代會被放大?

因為 AI 搜尋正在改變三件事(你要的那段可直接引用):

- 流量來源:不再只靠點擊排名,AI 會直接摘要答案

- 品牌曝光:曝光從「搜尋結果標題」變成「AI 摘要引用」

- 專業信任度:AI 更偏好穩定、可驗證、低錯誤率的來源

而 WordPress 主機,就是這場變化中最容易被忽略、卻最關鍵的一環。因為主機決定了「AI 能不能順利、持續、一致地取用你的內容」。

AI 搜尋正在放大「基礎架構差異」

在傳統搜尋(SEO)時代,網站多半只要做到「可被收錄、內容與關鍵字對得上、速度不要太差」,就有機會靠排名拿到點擊。

但 AI 搜尋(AI Overviews / Chat-based Search / Answer Engine)正在改變排序與曝光邏輯:它不是只選“排名高”的網站,而是選“最可信、可反覆驗證、可穩定存取”的來源來引用。

因此,你的 WordPress 主機與架構品質,會直接影響:AI 是否願意引用你、引用到哪一段、引用頻率有多高。這就是「基礎架構差異被放大」的原因。

AI 搜尋不是把網站“排個名”,而是直接把答案“組出來”。要被 AI 引用,網站必須在不同時間、不同節點、不同抓取策略下都能穩定回應並輸出一致內容。這使得 WordPress 主機與基礎架構差異被放大:速度與穩定性不再只是體感問題,而是直接影響 AI 是否選你當可信來源。

1. AI 搜尋不是一次抓取,而是「高頻、多樣化、反覆驗證」的存取模式

AI 系統在生成答案時,通常會:

- 反覆抓取同一主題的多個來源

- 對同一 URL 不同時間再抓一次(驗證一致性)

- 用不同 User-Agent / 不同地區節點 / 不同策略做取用

- 同時大量抓取(尤其當某主題熱門、或需要更新資訊)

結論:它更像“持續性的壓力測試”,而不是單次爬蟲收錄。

所以主機若有「時快時慢、偶發 5xx、偶發 timeout」,AI 會更快把你排除。

2. AI 引用需要「可重現的內容」,而主機與快取最容易導致版本漂移

AI 引用的核心要求是:

同一個 URL 的內容在合理時間內「可重現」(reproducible)與「可預期」(predictable)。

但 WordPress 很容易因為架構不同出現版本漂移,例如:

- 快取層太多,規則不清楚(CDN / LiteSpeed / Plugin / Object Cache)

- Cookie、登入狀態、User-Agent、Query string 沒處理好

- cache HIT/ MISS 行為不穩

- 後台更新後前台仍吐舊頁(或部分段落是新、部分是舊)

AI 看到的是:同一頁面輸出不一致,可信度下降。這會直接影響引用機率,而不是只影響「使用者體感」。

3. AI 會“真的去讀你的頁面”:錯誤率與穩定性變成排名級因素

傳統 SEO 的排名,很多時候是信號綜合評分;速度差一點可能只是排名掉幾名。

但 AI 引用更像「是否可用」的門檻判斷:

只要出現以下狀況,AI 就可能降低引用或停止引用:

- 429(被限流)

- 403(WAF 誤擋)

- 5xx(後端服務不穩)

- timeout(TTFB 太慢、回應時間過長)

- TLS/HTTP2/重導異常(請求鏈太長、跳轉不一致)

共享型主機最常見的問題,就是尖峰時錯誤率上升與回應不穩。

這在 AI 搜尋時代會被放大成「不被引用」的風險,而不只是「慢一點」。

4. “基礎架構差異”為什麼會被放大?因為曝光變成「引用」而不是「點擊」

你可以把差異理解成這句話:

- 以前:你只要排在前面,使用者點你,網站再慢也還有流量

- 現在:AI 先把答案整理好,你必須被 AI 引用,才有機會得到曝光與點擊

因此,基礎架構的差異被放大的方式包含:

- 流量來源改變:從「搜尋點擊」轉向「AI 引用導流 + 品牌曝光」

- 曝光形式改變:曝光不只看排名,更看你是否被摘要引用

- 信任評分改變:穩定、低錯誤率、可重現輸出,變成更關鍵的入選條件

下一步,企業該怎麼準備?

AI 搜尋並不是一個「未來趨勢」,而是已經開始重塑流量結構與品牌曝光方式的現實。

企業接下來要做的,不是單點調整,而是一次從「被搜尋」到「被引用」的整體升級。

這個準備過程,可以分成四個層次來思考。

1.從「排名導向」轉為「引用導向」的思維轉換

在 AI 搜尋時代,成功的目標已不再只是:

- 排名第幾名

- 點擊率高不高

而是:

- 是否被 AI 選為可信來源

- 是否被摘要、引用、重複提及

- 是否在沒有點擊的情況下,仍完成品牌曝光與專業背書

這代表企業需要開始用以下問題檢視網站:

- 我的內容是否能被 AI 清楚理解與拆解?

- AI 引用時,是否能快速且穩定存取頁面?

- 我是否在「可被信任的來源名單」中?

2.強化內容結構,而不只是增加內容數量

AI 不只是讀文字,它會「理解結構」。

企業應該開始系統性優化:

- H1 / H2 / H3 的語意清楚度

- 每一段是否有明確主題句(AI 容易摘要)

- FAQ、定義型段落、比較型段落是否明確

- Schema(FAQPage、Article、HowTo)是否正確標註

重點不在於寫更多文章,而是:

讓每一篇內容,都具備被 AI 摘要與引用的條件。

3.把「網站穩定性」視為品牌信任的一部分

在 AI 搜尋中,網站的技術表現,等同於品牌的可信度。

企業必須確保:

- 頁面在高頻抓取下仍穩定(不爆 5xx / timeout)

- TTFB 與回應時間波動小

- 快取輸出一致(避免同一 URL 不同版本)

- 不會因 WAF、限流策略誤擋 AI / 搜尋引擎

這也是為什麼:

WordPress 主機與基礎架構,會直接影響 AI 是否願意引用你的內容。

4.重新檢視 WordPress 主機是否「撐得起 AI 搜尋行為」

企業常忽略的一點是:

AI 搜尋帶來的,不只是使用者,而是高頻、持續、結構化的存取行為。

因此,主機架構必須具備:

- 資源隔離,避免他站影響

- 高效快取(頁面快取 + Object Cache)

- 穩定資料庫效能

- 可承受 AI / 搜尋爬蟲反覆抓取

- 長期一致的回應品質

如果主機本身就是瓶頸,再好的內容與 SEO,都會被放大缺點。

結論:為 AI 搜尋而生的 WordPress 主機,才是企業該選擇的基礎

AI 搜尋正在重新定義「誰值得被看見」。

在這個新時代,企業要競爭的已不只是搜尋排名,而是:

- 是否能被 AI 視為可信引用來源

- 是否能在沒有點擊的情況下,仍完成品牌曝光與專業背書

- 是否能在長期、高頻的 AI 存取下,維持穩定、一致、可預期的回應品質

這些條件,已經遠遠超出傳統 SEO 或內容行銷能單獨解決的範圍。

真正的關鍵,在於底層 WordPress 主機與整體架構,是否為 AI 搜尋行為而設計。

TAKI Cloud:為 AI 搜尋時代打造的 WordPress 主機解決方案

TAKI Cloud 並不是「再快一點的主機」,

而是從一開始,就以 AI 搜尋存取模式、可信引用邏輯、企業級穩定性 為核心所設計的 WordPress 架構。

我們的解決方案,專注解決企業在 AI 搜尋時代最容易忽略、卻最致命的問題:

- 高頻 AI / 搜尋引擎存取下的穩定回應

- 一致且可預期的頁面輸出,避免被 AI 判定為不可靠來源

- 資源隔離與效能保障,確保品牌網站不被其他站點影響

- 為 WordPress 內容結構、快取與資料庫行為最佳化的主機設計

這讓你的網站,不只是「能被搜尋到」,而是值得被 AI 長期引用、推薦與信任。

在 AI 搜尋時代,主機不只是成本,而是品牌信任的基礎

當 AI 成為使用者的第一個入口,

你的 WordPress 主機,實際上已成為:

品牌是否被看見、是否被信任、是否被引用的關鍵基礎設施。

TAKI Cloud 的 WordPress 主機解決方案,

正是為了幫助企業在這個轉變中,站在被選擇的一方,而不是被淘汰的一方。

FAQ|AI 搜尋時代與 WordPress 主機常見問題

是的,而且影響已經發生。AI 搜尋(如 Google AI Overview、ChatGPT、Perplexity)會直接在搜尋結果中整合答案,使用者不一定點擊網站。只有被 AI 視為「可信來源」的網站,才會被引用並獲得實質曝光與流量。

傳統 SEO 以「排名與點擊」為核心;AI 搜尋更重視:

- 內容是否結構清楚、語意明確

- 網站是否長期穩定、可重複存取

- 是否具備專業可信度(E-E-A-T)

主機穩定性與技術架構,成為 AI 是否引用網站的關鍵因素。

AI 系統在引用內容前,會實際存取網站頁面。

若主機出現以下情況,AI 可能降低引用機率:

- 回應速度不穩定

- 高頻存取時出現錯誤或 timeout

- 快取與頁面輸出不一致

因此,主機品質直接影響 AI 對網站的「信任度」。

對個人或小型網站尚可,但對企業品牌風險較高。

共享主機常見問題包括:

- 資源爭用造成效能波動

- 高峰期回應不一致

- 無法因應 AI 與搜尋引擎的高頻抓取行為

在 AI 搜尋時代,這些都可能影響品牌曝光與專業形象。

對網站的「信任度」。